1、概述

数据库分库分表后就会涉及到如何写入和读取数据的问题,应用开发人员主要关心如下几个问题:

- 是否需要在应用层做改造来支持分库分表,即是在应用层进行支持,还是通过中间件层。

- 如果需要应用层做支持,那么分库分表的算法是什么。

- 分库分表后,join是否支持,排序分页是否支持,事务是否支持。

1.1、应用层还是中间件层

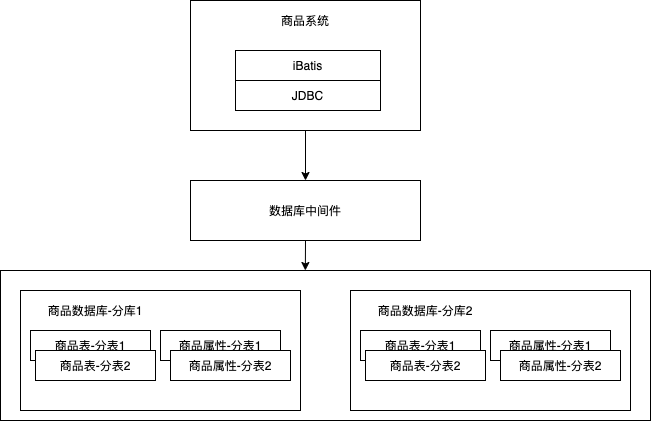

分库分表可以在应用层实现,也可以在中间件层实现,中间件层实现的好处是对应用透明,应用就像查单库表一样去查询中间件层。

使用数据库中间件层还有一个好处是可以支持多种编程语言,而不受限于特定的语言。使用数据库中间件层可以减少应用的总数据库连接数,从而避免因为应用过多导致数据库连接不够用。缺点是除了维护中间件外,还要考虑中间件的HA/负载均衡等,增加了部署和维护的困难,因此,还是要看当前阶段有没有必要使用中间件和有没有人维护该中间件。

而应用层可以在JDBC驱动层、DAO框架层,如iBatis/Mybatis/Hibernate/JPA上完成。

应用系统直接在应用代码中耦合了分库分表逻辑,然后通过如iBatis/JDBC直接分库分表实现。

1.2、分库分表策略

分库分表策略是指按照什么算法或规则进行存储,它会影响数据的写入和读取,比如,按照订单ID分库分表,那么就很难按照客户纬度进行订单查询。因此,在进行分库分表时需要慎重考虑使用什么策略。常见的策略有取模、分区、路由表等。

(1)、取模

我们可以按照数值型主键取模来进行分库分表,也可以按照字符串主键哈希取模进行分库分表,常见的如订单表按照订单ID分库分表,用户订单表按照用户ID分库分表,产品表按照产品ID分库分表。取模的优点是数据热点分散,缺点是按照肺主键纬度进行查询时需要跨库/跨表查询,扩容需要建立新集群并进行数据迁移。如果想减少扩容时带来的麻烦,可以在初期规划时冗余足够数量的分库分表。如果遇到容量问题,则可以按照如下步骤进行扩容。

每台物理机上有两个数据库实例,当遇到数据库性能瓶颈时,首先可以通过升级硬件解决,如HDD换成SATA SSD、SATA SSD换成PCIe SSD或NVMe SSD,升级硬件之后,瓶颈可能是磁盘空间或者网卡带宽。如果还是不能解决性能问题,接着通过扩容物理机来解决性能瓶颈。

当通过扩容物理机无法解决性能问题或者当单表容量遇到瓶颈,可以进行成倍扩容,成倍扩容后的数据迁移过程可以这样实现,先挂数据库主从,当数据库主从同步完成后,停应用写数据库并等待一段时间以保证主从同步完成,接着更新分库分表规则并启动应用进行写库,最后删除各个库的冗余数据即可。

分库/分表策略:使用sharding-columns指定分库分表键,algorithm-expression指定分库分表策略,我们按照ID分了两个表,每个库两站表。算法为:库ID=id%库数量,表ID=id/库数量%单库表数量。另一种算法为:库ID=id%表总数量/单库表数量,表ID=id%表总数量。

1.3、线上分库分表方案

本方案的基础环境如下:JDK1.8、Springboot+mybatis+hikariCP

(1)、首先引入相关依赖:

<dependency>

<groupId>com.dangdang</groupId>

<artifactId>sharding-jdbc-self-id-generator</artifactId>

<version>1.4.2</version>

</dependency>

<dependency>

<groupId>org.apache.shardingsphere</groupId>

<artifactId>sharding-jdbc-spring-boot-starter</artifactId>

<version>4.0.0-RC1</version>

</dependency>

(2)、在application.properties中配置相关数据

spring.shardingsphere.datasource.names=master

# 数据源

spring.shardingsphere.datasource.master.type=com.zaxxer.hikari.HikariDataSource

spring.shardingsphere.datasource.master.driver-class-name=com.mysql.jdbc.Driver

spring.shardingsphere.datasource.master.username=***

spring.shardingsphere.datasource.master.password=***

spring.shardingsphere.datasource.master.jdbcUrl=jdbc:mysql://***:***:***:***:3306/mybatis

# 分表配置

spring.shardingsphere.sharding.tables.user.actual-data-nodes=master.user_${0..2}

spring.shardingsphere.sharding.tables.user.table-strategy.inline.sharding-column=sharding_id

spring.shardingsphere.sharding.tables.user.table-strategy.inline.algorithm-expression=user_${sharding_id.longValue() % 3}

(3)、在数据库中建立拆分后的表

(4)、引入分布式主键字段:比如sharding_id,因为多个表之间的主键生成策略是重叠的,主键无法拿来直接使用,这里通过新引入一个bigint类型的字段来保证数据在插入时对于多个表之间的ID是唯一的。

// 主键生成器

@Bean

public IdGenerator getIdGenerator() {

return new CommonSelfIdGenerator();

}

// 获取主键值

idGenerator.generateId().longValue();

这样就可以保证数据插入时按照主键来选择插入的表user_0,user_1,user_2。

分库分表方案

一、数据库瓶颈

不管是IO瓶颈,还是CPU瓶颈,最终都会导致数据库的活跃连接数增加,进而逼近甚至达到数据库可承载活跃连接数的阈值。在业务Service来看就是,可用数据库连接少甚至无连接可用。接下来就可以想象了吧(并发量、吞吐量、崩溃)。

1、IO瓶颈

-

第一种:磁盘读IO瓶颈,热点数据太多,数据库缓存放不下,每次查询时会产生大量的IO,降低查询速度 -> 分库和垂直分表。

-

第二种:网络IO瓶颈,请求的数据太多,网络带宽不够 -> 分库。

2、CPU瓶颈

-

第一种:SQL问题,如SQL中包含join,group by,order by,非索引字段条件查询等,增加CPU运算的操作 -> SQL优化,建立合适的索引,在业务Service层进行业务计算。

-

第二种:单表数据量太大,查询时扫描的行太多,SQL效率低,CPU率先出现瓶颈 -> 水平分表。

二、分库分表

1、水平分库

概念:以字段为依据,按照一定策略(hash、range等),将一个库中的数据拆分到多个库中。

结果:

- 每个库的结构都一样;

- 每个库的数据都不一样,没有交集;

- 所有库的并集是全量数据;

场景:系统绝对并发量上来了,分表难以根本上解决问题,并且还没有明显的业务归属来垂直分库。

分析:库多了,io和cpu的压力自然可以成倍缓解。

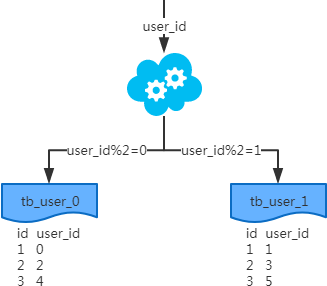

2、水平分表

概念:以字段为依据,按照一定策略(hash、range等),将一个表中的数据拆分到多个表中。

结果:

- 每个表的结构都一样;

- 每个表的数据都不一样,没有交集;

- 所有表的并集是全量数据;

场景:系统绝对并发量并没有上来,只是单表的数据量太多,影响了SQL效率,加重了CPU负担,以至于成为瓶颈。推荐:一次SQL查询优化原理分析

分析:表的数据量少了,单次SQL执行效率高,自然减轻了CPU的负担。

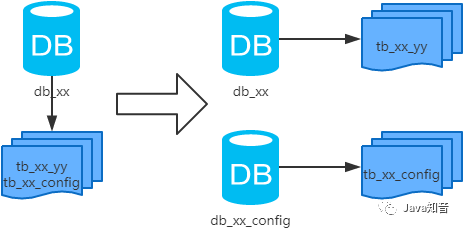

3、垂直分库

概念:以表为依据,按照业务归属不同,将不同的表拆分到不同的库中。

结果:

- 每个库的结构都不一样;

- 每个库的数据也不一样,没有交集;

- 所有库的并集是全量数据;

场景:系统绝对并发量上来了,并且可以抽象出单独的业务模块。

分析:到这一步,基本上就可以服务化了。例如,随着业务的发展一些公用的配置表、字典表等越来越多,这时可以将这些表拆到单独的库中,甚至可以服务化。再有,随着业务的发展孵化出了一套业务模式,这时可以将相关的表拆到单独的库中,甚至可以服务化。

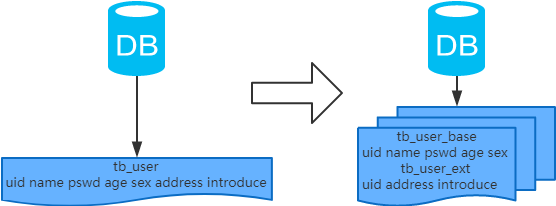

4、垂直分表

概念:以字段为依据,按照字段的活跃性,将表中字段拆到不同的表(主表和扩展表)中。

结果:

- 每个表的结构都不一样;

- 每个表的数据也不一样,一般来说,每个表的字段至少有一列交集,一般是主键,用于关联数据;

- 所有表的并集是全量数据;

场景:系统绝对并发量并没有上来,表的记录并不多,但是字段多,并且热点数据和非热点数据在一起,单行数据所需的存储空间较大。以至于数据库缓存的数据行减少,查询时会去读磁盘数据产生大量的随机读IO,产生IO瓶颈。

分析:可以用列表页和详情页来帮助理解。垂直分表的拆分原则是将热点数据(可能会冗余经常一起查询的数据)放在一起作为主表,非热点数据放在一起作为扩展表。这样更多的热点数据就能被缓存下来,进而减少了随机读IO。拆了之后,要想获得全部数据就需要关联两个表来取数据。

但记住,千万别用join,因为join不仅会增加CPU负担并且会讲两个表耦合在一起(必须在一个数据库实例上)。关联数据,应该在业务Service层做文章,分别获取主表和扩展表数据然后用关联字段关联得到全部数据。

三、分库分表工具

- sharding-sphere:jar,前身是sharding-jdbc;

- TDDL:jar,Taobao Distribute Data Layer;

- Mycat:中间件。

注:工具的利弊,请自行调研,官网和社区优先。

四、分库分表步骤

根据容量(当前容量和增长量)评估分库或分表个数 -> 选key(均匀)-> 分表规则(hash或range等)-> 执行(一般双写)-> 扩容问题(尽量减少数据的移动)。

扩展:MySQL:分库分表与分区的区别和思考

五、分库分表问题

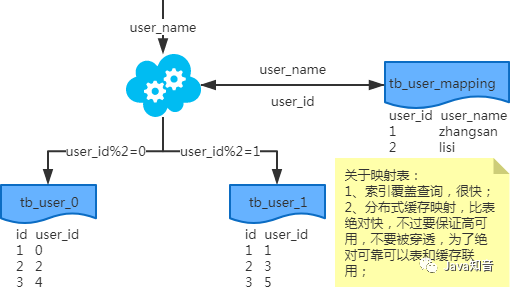

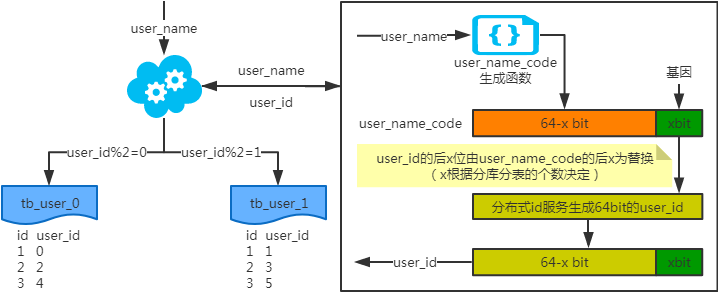

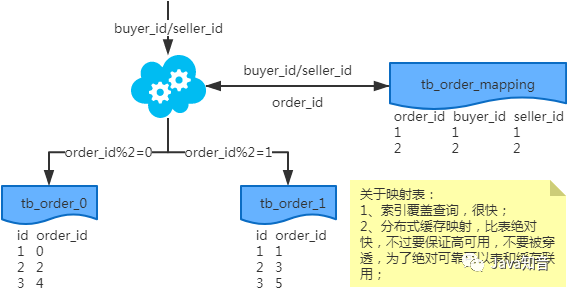

1、非partition key的查询问题

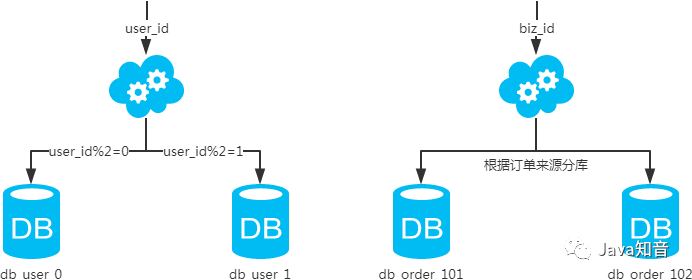

基于水平分库分表,拆分策略为常用的hash法。

端上除了partition key只有一个非partition key作为条件查询

映射法

基因法

注:写入时,基因法生成user_id,如图。关于xbit基因,例如要分8张表,23=8,故x取3,即3bit基因。根据user_id查询时可直接取模路由到对应的分库或分表。

根据user_name查询时,先通过user_name_code生成函数生成user_name_code再对其取模路由到对应的分库或分表。id生成常用snowflake算法。

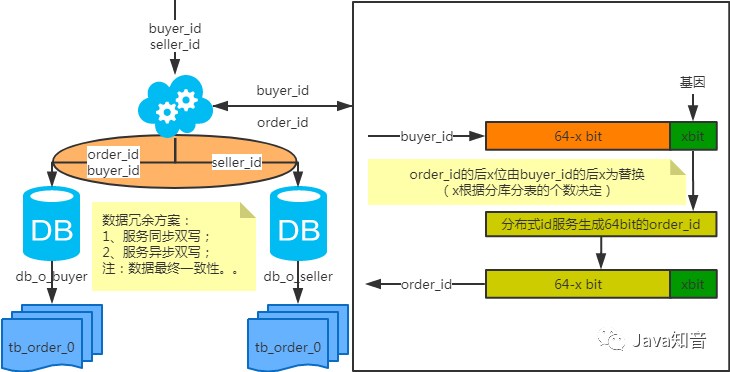

端上除了partition key不止一个非partition key作为条件查询

映射法

冗余法

注:按照order_id或buyer_id查询时路由到db_o_buyer库中,按照seller_id查询时路由到db_o_seller库中。感觉有点本末倒置!有其他好的办法吗?改变技术栈呢?

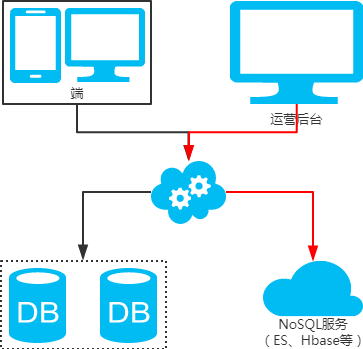

后台除了partition key还有各种非partition key组合条件查询

NoSQL法

冗余法

2、非partition key跨库跨表分页查询问题

基于水平分库分表,拆分策略为常用的hash法。

注:用NoSQL法解决(ES等)。

3、扩容问题

基于水平分库分表,拆分策略为常用的hash法。

水平扩容库(升级从库法)

注:扩容是成倍的。

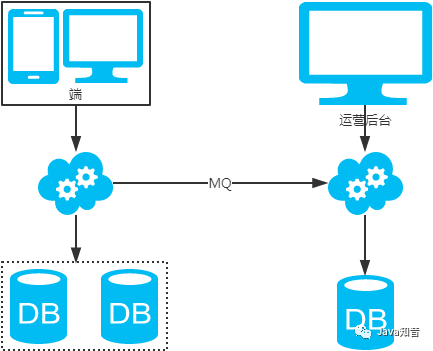

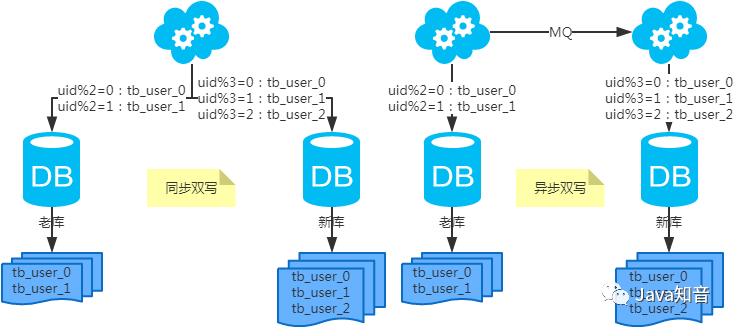

水平扩容表(双写迁移法)

- 第一步:(同步双写)修改应用配置和代码,加上双写,部署;

- 第二步:(同步双写)将老库中的老数据复制到新库中;

- 第三步:(同步双写)以老库为准校对新库中的老数据;

- 第四步:(同步双写)修改应用配置和代码,去掉双写,部署;

注:双写是通用方案。

六、分库分表总结

- 分库分表,首先得知道瓶颈在哪里,然后才能合理地拆分(分库还是分表?水平还是垂直?分几个?)。且不可为了分库分表而拆分。

- 选key很重要,既要考虑到拆分均匀,也要考虑到非partition key的查询。

- 只要能满足需求,拆分规则越简单越好。